R界的“party”时刻:决策树轻松get,别告诉我R语言不懂机器学习!!!

R界的“party”时刻:决策树轻松get,别告诉我R语言不懂机器学习!!!

公众号后台回复“111”

领取本篇代码、基因集或示例数据等文件

文件编号:240201

需要租赁服务器的小伙伴可以扫码添加小果,此外小果还提供生信分析,思路设计,文献复现等,有需要的小伙伴欢迎来撩~

ctree(formula, data, subset = NULL, weights = NULL,controls = ctree_control(), xtrafo = ptrafo, ytrafo = ptrafo,scores = NULL)str(iris)

iris数据集:'data.frame': 150 obs. of 5 variables:$ Sepal.Length: num 5.1 4.9 4.7 4.6 5 5.4 4.6 5 4.4 4.9 ...$ Sepal.Width : num 3.5 3 3.2 3.1 3.6 3.9 3.4 3.4 2.9 3.1 ...$ Petal.Length: num 1.4 1.4 1.3 1.5 1.4 1.7 1.4 1.5 1.4 1.5 ...$ Petal.Width : num 0.2 0.2 0.2 0.2 0.2 0.4 0.3 0.2 0.2 0.1 ...$ Species : Factor w/ 3 levels "setosa","versicolor",..: 1 1 1 1 1 1 1 1 1 1 ...

install.packages('party')library(party)

还安装相依关系‘TH.data’, ‘libcoin’, ‘matrixStats’, ‘multcomp’, ‘mvtnorm’, ‘modeltools’, ‘strucchange’, ‘coin’, ‘zoo’, ‘sandwich’

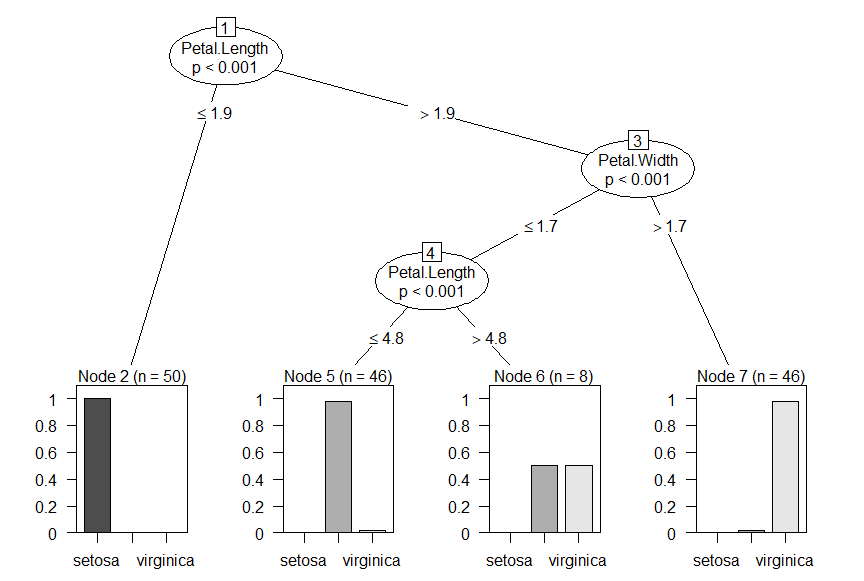

install.packages('grid')install.packages('mvtnorm')install.packages('modeltools')install.packages('stats4')install.packages('strucchange')install.packages('zoo')library(grid)library(mvtnorm)library(modeltools)library(stats4)library(strucchange)library(zoo)接下来,将将iris数据集作为构建决策树的数据集,使用ctree来构建决策树即可:data <- irisprint("This is decision tree data")print(data)myFormula <- Species ~ Sepal.Length + Sepal.Width + Petal.Length + Petal.Widthiris_ctree <- ctree(myFormula, data=data)

Conditional inference tree with 4 terminal nodesResponse: SpeciesInputs: Sepal.Length, Sepal.Width, Petal.Length, Petal.WidthNumber of observations: 1501) Petal.Length <= 1.9; criterion = 1, statistic = 140.2642)* weights = 501) Petal.Length > 1.93) Petal.Width <= 1.7; criterion = 1, statistic = 67.8944) Petal.Length <= 4.8; criterion = 0.999, statistic = 13.8655)* weights = 464) Petal.Length > 4.86)* weights = 83) Petal.Width > 1.77)* weights = 46

plot(iris_ctree)

小果还提供思路设计、定制生信分析、文献思路复现;有需要的小伙伴欢迎直接扫码咨询小果,竭诚为您的科研助力!

定制生信分析

服务器租赁

扫码咨询小果

往期回顾

|

01 |

|

02 |

|

03 |

|

04 |